un site sur l'affiliation adulte

Dans la peau de Google

Un jour on demanda à Cavanna de se prêter avec d’autres personnalités à un test de QI pour un magazine et il fut le premier avec un score de 150 ! Stupeur des journalistes et réponse de Cavanna : “rien de plus facile à réussir, il suffit de se mettre dans la peau du con qui créa ce test”.

Bien sûr les créateurs de Google sont très loin d’être des cons, mais se mettre dans leurs peaux est un exercice qui permet de rendre cohérent ce qui semble anarchique ou chaotique au simple regard.

Sortons du raisonnement et de la pensée du webmaster pour avoir celle de créateur et patron de Google.

Si je partage avec vous ces réflexions, c’est que depuis 1994 je n’ai jamais été un webmaster. J’ai toujours pensé en entrepreneur, patron d’agence web (mon plus beau cauchemar), consultant de haut niveau pour le CAC40 ou McKinsey, formateur, co-actionnaire d’un fond d investissement technologique aux US, avec comme vous mon lot d’échecs et quelques succès qui m’ont mis à l’abri du besoin pour plusieurs générations.

Le xbiz c’est enfin pouvoir m’amuser sur le web sans être politiquement correct ou avoir à rendre des comptes aux employés, syndicats ou actionnaires.

Cette petite chronique est le fruit de rencontres, de mon humble expérience et de plusieurs visites dans les bureaux de Google au fil des années comme gros clients ou plus simplement comme invité lors de présentation de Matt Cutts ou d’autres ingénieurs plus techniques.

Google et les webmasters : je t’aime moi non plus

Google n’est pas à votre service : il est depuis ses débuts au service des internautes et lors sa création il y avait pléthore d’annuaires et de moteurs de recherches avec bien plus de trafic.

En tant que Larry Page, vous voulez créer un moteur qui doit rendre les internautes accros par sa rapidité à donner des résultats pertinents et à indexer le plus de pages web. Vous êtes a la base un esprit logique, un mathématicien et avec pour père Carl Page, un pionnier de l’informatique et de l’intelligence artificielle.

Votre projet commence par un travail universitaire sur les algorithmes, votre passion et c’est à Stanford que vous aurez gratuitement vos premiers gros serveurs, car au début on ne parle pas d’argent et il n y a pas de publicités ou de revenus.

Votre contenu va être celui des sites que vous indexez, avec dans votre algorithme une préférence pour ceux qui ont le plus de pages, de mots clefs mais sans jamais lire ou comprendre le texte et son intérêt pour celui qui fait la requête.

Les webmasters reçoivent plein de trafic GRATUIT et encensent Google. Il faut dire que à cette époque ceux qui se donnent la peine de faire un site ne les font pas a la chaîne avec du spin et que les réponses sont pertinentes, avec un algorithme bien pensé mais pas aussi raffiné qu’aujourd’hui, sans les milliers de linguistes, sémiologues et experts en intelligence artificielle payés à prix d or.

Mais revenons à vos début comme créateur de Google. Tout d’abord il faudra acheter un gros disque dur de 1 téraoctets et à l’époque c’est 15 000 USD. Les premiers business angels, dont le patron de Sun et des amis et membres de la famille permettent de réunir un million de dollars, ce qui est peu et beaucoup à la fois.

Mais votre idée de base est surtout de créer une killer app qui concentre tout le contenu du web de l’époque avec une pertinence et rapidité de recherche inconnue à l’époque. Ce n’est pas de créer une société mais de revendre le brevet au leader de l’époque, Yahoo, dont le patron a un peu investi à titre personnel, puis de rentrer chez Yahoo pour continuer le projet.

Mais Yahoo et d’autres ne sont pas intéressés alors par dépit vous créez votre société, au début dans un esprit Wikipedia, sans publicité ni plan marketing, un peu comme des encyclopédiste du web. De cette époque né le management en petits groupes de travail, avec une liberté de créer et aussi un certain chaos qui laisse parfois pantois ou inquiets en tant que webmaster.

Mais rapidement, dès 1998, le besoin d’argent se fait sentir alors que votre moteur demande d’énormes ressources financières avec ses 500 000 requêtes par jours. Votre moteur fait partie des 100 sites les plus importants du monde et Séquoia Capital rentre au capital.

Google devient commercial et pour monétiser l’encyclopédie vous devenez le plus puissant moteur publicitaire contextuel, dépassant tous vos concurrents dont Altavista. Les webmasters sont encore les rois tant qu’ils fournissent du contenu frais car Google se nourrit de contenus et doit répondre à toutes les requêtes sans intervention humaine.

La philosophie de Google est dans son algorithme et les hommes de Google a son service.

Comprenons la pensée de nos deux créateurs, toujours au cœur de Google malgré la pression des financiers.

Google comme Coca Cola a inventé le marketing de la formule magique, mais l’algorithme est devenu une usine à gaz, avec à son service des centaines de savants, linguistes couvrant toutes les langues du globes, ingénieurs en intelligence artificielle ou experts en programmation, travaillant tous sans trop de communication mais contribuant séparément à rendre l’algorithme le plus proche possible de la pensée humaine.

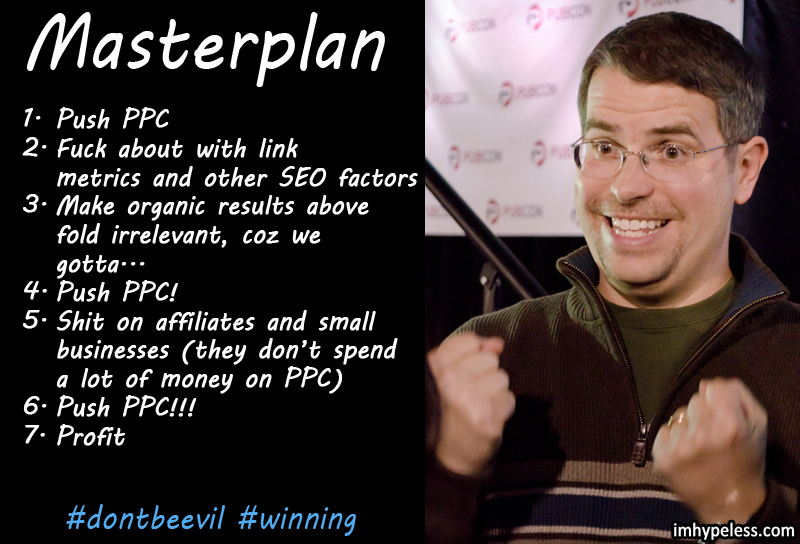

Aujourd’hui Matt Cutts comme Larry Page ou Sergei Brin seraient bons derniers dans un concours SEO sur leur propre moteur (en privé ils en rigolent eux-mêmes). Matt Cutts prêche la bonne parole pour dissuader le webmaster moyen de détourner du trafic sur des mots clefs rémunérateurs et les obliger à fournir du contenu.

Google aime et met en avant Wikipedia dont il est un principaux contributeurs financiers en terme de dons. Google achète aussi non plus des brevets mais des bases de données mondiales comme ITA, pour le voyage les guides Frommer’s ou Zagat pour la gastronomie, et met en avant les sites des journaux et des magazines.

De plus en plus il lui faut du contenu fiable, reconnu et apprécié des internautes.

Google et son système radar anti-missiles SEO

Google compte beaucoup de monde en logistiques informatique, programmation, marketing, communication, juridique et relations commerciales avec les agences publicitaires et les gros clients, chacun bien cloisonnés. Et pour obtenir un avantage il faut trouver et devenir ami avec le bon contact, souvent un manager de second rang qui peut plus que tous les directeurs.

Mais il y a très peu de ressources humaines internes pour noter et évaluer les sites car c’est le rôle du sacro-saint Algorithme. Le recours à l’humain pour évaluer est un constat d’échec et un ultime recours.

En résumé le système est automatisé avec une marge d erreur de 5 a 7 % via une sorte de radar qui scrute en permanence chaque site. Le radar repère toutes les variations significatives comme des suppressions massives de liens, des redirections incongrues, des backlinks connus comme suspects, des non-mises à jour sur de longue période et toute les incohérences flagrantes.

Le radar repère les facteurs négatifs et positifs.

Un bon black hat passe toujours en-dessous des ondes négatives du radar mais parfois se fait cramer, ça fait partie du jeu. Si le radar vous repère alors vous passez au mode de révision humain, ce que déteste Google car malgré les consignes données aux réviseurs de sites, ce mode de contrôle est forcément subjectif, comme tout ce qui est humain.

Rassurez-vous, personne chez Google ne perdra son temps à vérifier votre site, ça sera le travail des employés d’un sous-traitant, qui devra faire du chiffre en termes du nombre de sites contrôlés, avec un minimum d’erreurs. Mais même avec ces erreurs Google préfère ça au système de notation par les internautes, qui s’est révélé bien pire après plusieurs tests live.

La demande de révision est le dernier recours car Google la fait en interne, ce qui coûte de l’argent et emmerde tout le monde chez lui.

La méthode officieuse est simple : pour traiter des centaines de milliers de demandes, on distribue automatiquement vers un employé parlant la langue et il va jeter rapidement un coup d’œil selon le principe du “j’ai envie d’en voir plus et le site est intéressant point vu contenu et technique” ou “il me fatigue pour pas dire me fait chier”.

Conclusion, si honnêtement comme internaute votre site est chiant, digne de déclencher une crise d’épilepsie et sans contenu intéressant, ne demandez jamais une révision. Laissez tomber et avec un peu de patience et des modifications le radar améliorera sa position au prochain passage car aucun site ne disparaît de la base et le radar repasse toujours le visiter surtout avec du contenu frais régulier. Une autre astuce est d’avoir une forte augmentation de requêtes des internautes genre monsite.fr.

Si votre site est vraiment valable alors tentez une demande motivée, et renvoyez-là plusieurs fois si vous n’avez pas de réponses (ce qui est souvent le cas). Un employé de Google finira par aller le voir même si ça prend 6 mois. J’ai aussi le témoignage d’un ami avec un très bon site innovant mais peu visible qui tenta volontairement le coup alors qu’il n’avait aucune pénalité, juste un mauvais SEO, et ce fut le gros lot pour lui car tout est possible avec Google.

Google, ses sources de revenus et les webmasters

Les revenus publicitaires représentent encore 85 à 90 % du chiffre d’affaires de Google. Les ventes de matériels restent anecdotiques, comme la vente de services et applications aux grandes entreprises comme Google Map ou Analytics.

Google se concentre donc sur la maximisation de ces revenus avec deux axes stratégiques.

1. Augmenter le budget investi en publicité en augmentant les bids sur les AdWords concurrentiels tout en diminuant le partage des revenus via AdSense.

Google mise sur les grosses agences et les gros budgets en assurant plus de services et d’assistances au ROI, mais aussi plus discrètement en rendant indispensables les investissements et en augmentant le nombre d’entrants sur les segments les plus concurrentiels.

Prenons par exemple la location de voitures. Selon les pays on compte au total 10 à 30 gros annonceurs AdWords dont les gros du secteurs comme Avis. En laissant passer des sites black hat sur une première page, on diminue considérablement la chance d’y figurer même pour un gros. Car au final avec le nouveau design de la première page de résultat, entre Google Maps, YouTube et Wikipedia, il reste bien moins que 10 positions à prendre. On augmente alors le niveau des bids, le nombre de concurrents et le total du budget investi par segment et même par keywords pour ceux permettant un max de ROI.

L’autre axe financier est de diminuer la part du gâteau à partager avec les éditeurs de sites, tout en gardant les plus gros et influents.

Les nouveaux filtres Pinguin et Panda y contribuent en éliminant les MFA des petits webmasters, le tout combiné avec une rémunération au clic très variable. Ainsi pour un clic sur le keyword “hôtel Barcelone” le webmaster positionné percevra bien moins que le site d’un grands média reconnu.

Google ne s’en cache pas : un clic sur ce mot clé peut valoir en théorie 1,20 euros pour l’annonceur mais pour l’éditeur ne rapporter que 0,10 euro ou 0,60 euro selon la notoriété de son site et divers facteurs assez obscurs, qu’on imagine liés à un algorithme secret dédié à la gestion des revenus publicitaire. En tout cas le CA net (une fois déduits les reversements publicitaires) est en croissance, ce qui plait aux analystes et fait monter le cours en bourse.

2. Devenir indispensable pour la vie quotidienne dans un futur à 10 ans

Ca explique la Google Car liée à Google Maps, les Google Glass, les Ultrabooks Google (segment stratégique d’Android) et bientôt la montre Google. A contrario les réseaux sociaux sont moins stratégiques que l’on pense pour Google et beaucoup de projets furent abandonnés ces dernières années car ne rentrants pas dans cette vision.

Tout ça pour expliquer que deux visions du biz doivent s’adapter à Google :

- celle des BH, mouvante et en constant arbitrage entre évolutions techniques et choix des niches.

- une vision plus durable qui doit s’appuyer sur un trafic plus varié avec un mix réseaux sociaux, buzz, fidélisation des visiteurs, e-whoring, et donner une valeur ajoutée intéressante pour Google en terme de contenus, d’outils ou de notoriété.

Un autre point à prendre en compte est que l’internaute mieux éduqué fait des requêtes de plus en plus précises et que les mots clés génériques ne font plus autant de ROI que les groupes de mots clés. Votre SEO doit donc être plus axé sur le ROI pour des mots clés moins concurrentiels et pour lesquels Google vous positionnera mieux.

Le Xbiz est pour l’instant avantagé face au mainstream, et Google au vu du nombre de requêtes sur le porn n’a pas envie de se montrer puritain, d’autant que ses concurrents comme Bing (qui représente encore 30 % de part de marché aux USA) se feront une joie d’y répondre et de fidéliser les internautes fans de cul. C’est bien connu, quand on veux trouver pour assouvir ses besoins on fait des efforts et on trouve…

| Google Bookmarks |

|

| Imprimer le billet | Ce billet a été posté par Olivier le 29/05/2013 à 14:44 dans la catégorie Idées. Suivez le flux RSS des commentaire de ce billet. Vous pouvez laisser un commentaire ou une question. Les pings sont désactivés. |

about 11 years ago

Excellent article .

J’ai beaucoup aimé la lecture, et la synthèse .

Merci

about 11 years ago

Ouep super article 😉

about 11 years ago

Intéressant et interpellant.

Pour toi, google a donc intérêt à laisser les sites spammy ranker en première page. A le fois parceque ca va inciter les annonceurs à investir en adword et parceque ca va inciter les utilisateur à faire confiance aux pubs plus qu’au résultats naturel.

about 11 years ago

Merci d’avoir pris le temps de rédiger cet article, c’est très intéressant et très clair :clapping:

about 11 years ago

Pour toi, google a donc intérêt à laisser les sites spammy ranker en première page. A le fois parceque ca va inciter les annonceurs à investir en adword et parceque ca va inciter les utilisateur à faire confiance aux pubs plus qu’au résultats naturel.

je me souviens avoir lu un article qui démontrait que les premières pages des requetes les plus rentables comme “rachat de crédit” , “voyage au maroc” étaient complètement spammées par des sites aux techniques BH, après est ce gg qui laisse faire ou les BH qui sont trop fort…

Surtout que comme la écrit Hitman dans son article, les sites à faible valeur sont plus rentables pour lui car il rémunère moins leurs PPC

about 11 years ago

Très très bon 🙂

about 11 years ago

C’est du très bon tout ça Hitman, chapeau !

Je lis la deuxième partie dès que j’arrive chez moi 🙂

about 11 years ago

Vraiment très intéressant à lire

about 11 years ago

Belle analyse, et la conclusion est intéressante, nottamment sur l’obligation qu’à Google de garder ces internautes aux recherches un peu coquines tout en préservant une image de moteur propre.

about 11 years ago

Pour toi, google a donc intérêt à laisser les sites spammy ranker en première page. A le fois parceque ca va inciter les annonceurs à investir en adword et parceque ca va inciter les utilisateur à faire confiance aux pubs plus qu’au résultats naturel.

Oui c’est une société côté en bourse et soumise aux dictat des analystes et actionnaires

about 11 years ago

C’est très américain image puritaine mais le biz avant tout et les US sont les plus gros producteurs de porn lol FaceBook et lui puritain pur et dur même un tableau de Monet avec un nu est censuré.

about 11 years ago

Réflexion très intéressante, mais en irréductible gaulois je ne suis pas d’accord avec la partie qui consiste à penser que toute la stratégie naturelle de google sert à soutenir adwords.

Je pense que la vision de google est plus à long terme. Son univers concurrentiel a évolué, les risques pesant sur ses parts de voix sont importants. Face à l’indexation sociale (idée originellement développée par alta vista), google a peur de perdre en pertinence, et de perde par voie de conséquence les internautes qui recherchent.

Ce qui permet à Adwords de maintenir des prix élevés c’est la volumétrie disponible et le placement en tout début de la chaîne d’achat. Si demain les internautes trouvent l’information sans son intermédiaire, il n’aura plus de raison d’être. Et ce qui peut faire bouger les internautes c’est un service plus fiable et encore plus utilisé.

MY 2 cents.

about 11 years ago

Ptin auré, faut vraiment que tu postes plus souvent à la maison !

about 11 years ago

Je t’ai promis de faire un effort, d’ailleurs faudrait que je commence par l’avatar :p

about 11 years ago

En effet 😀

about 11 years ago

Merci pour cet article très enrichissant 🙂

about 11 years ago

Réflexion pertinente de Aurelien. Il nempêche que Adword (et son interface) donne une idée assez claire de la “logique” Google. Tout bon webmaster devrait avoir créer un compte sur adword et regarder ce qu’il s’y passe, même sans dépenser un euro. c’est très intéressant. ensuite faites la même chose sur Bing, et comparez.

about 11 years ago

Un bel article merci pour le partage .